Содержание

Apple впервые рассказывает о комплекте ARKit 2

НОВОСТЬ

4 июн 2018

Теперь разработчики смогут создавать самые передовые AR-приложения для крупнейшей в мире платформы дополненной реальности.

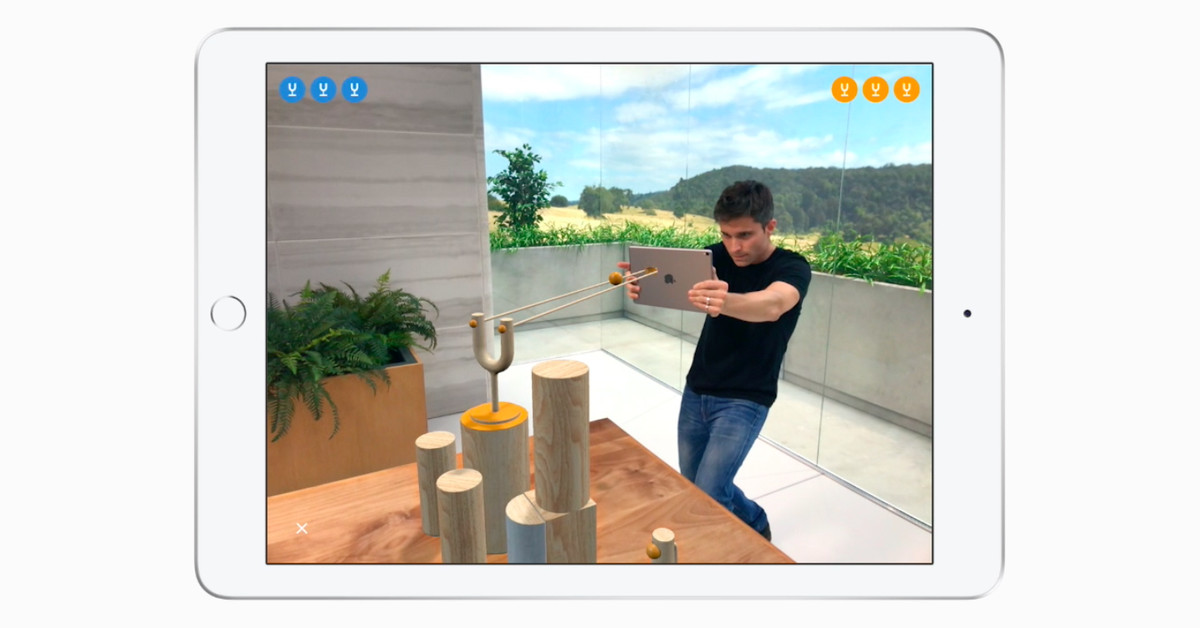

Приложение LEGO AR City оживляет объекты и персонажей LEGO, задействуя функции ARKit 2, в том числе единое пространство дополненной реальности, постоянные объекты и распознавание 3D-моделей.

Сегодня компания Apple представила ARKit 2 — платформу, на которой разработчики смогут создавать единые пространства дополненной реальности и постоянные объекты с привязкой к конкретным местам, а также задействовать распознавание объектов и отслеживание изображений. Теперь приложения дополненной реальности станут ещё более динамичными. Компания Apple также впервые представила приложение Measure для iOS, которое будет задействовать дополненную реальность для быстрой оценки размеров реальных объектов, и новый открытый формат файлов . usdz для iOS 12, созданный для ещё более тесной интеграции дополненной реальности в iOS и доступа к AR-объектам из любых приложений Apple.

usdz для iOS 12, созданный для ещё более тесной интеграции дополненной реальности в iOS и доступа к AR-объектам из любых приложений Apple.

С момента выпуска комплекта ARKit прошлой осенью компания Apple активно расширяла возможности дополненной реальности, доступные разработчикам. Новый комплект стал уже третьим выпуском ARKit. Он даёт разработчикам инструменты для создания приложений, помогающих пользователям iOS по-новому взглянуть на мир, работать эффективнее и увлекательнее.

ARKit 2

Теперь разработчики смогут встраивать функции для многопользовательских игр.

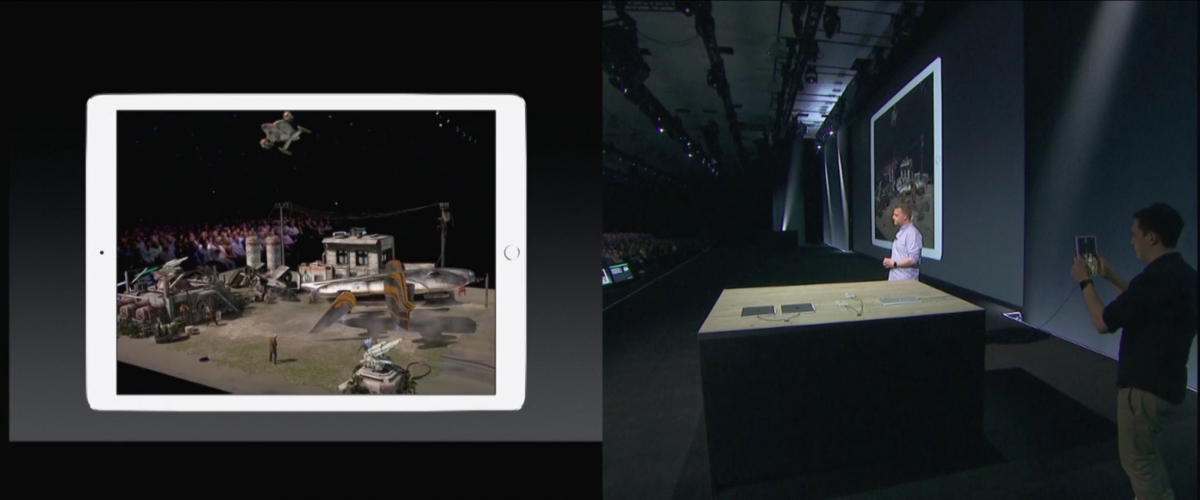

Единые пространства дополненной реальности в ARKit 2 делают дополненную реальность на iPhone и iPad ещё более увлекательной. Пользователи теперь смогут совместно играть или работать над проектами, например планировать ремонт в квартире. Разработчики смогут также добавлять режим зрителя: друзья и близкие смогут наблюдать за игрой в дополненной реальности с другого устройства iOS.

Разработчики смогут также добавлять режим зрителя: друзья и близкие смогут наблюдать за игрой в дополненной реальности с другого устройства iOS.

Постоянные объекты изменят принципы взаимодействия с AR-приложениями: пользователи смогут оставлять виртуальные объекты в реальном мире, а затем возвращаться к ним. Например, можно оставить на столе наполовину собранный пазл, и все его детали останутся на прежних местах. Или можно работать над художественным проектом в течение нескольких недель, не начиная каждый раз заново.

Единые пространства дополненной реальности дают возможность смотреть происходящее в качестве зрителя: видеть то, что видят игроки, и даже немного больше.

В ARKit 2 также расширена поддержка распознавания и отслеживания изображений. Это позволяет распознавать 3D-объекты, например игрушки и скульптуры, а также автоматически накладывать тени и блики от реальных объектов на объекты дополненной реальности. AR-пространство становится ещё более реалистичным смешением виртуального и реального миров.

AR-пространство становится ещё более реалистичным смешением виртуального и реального миров.

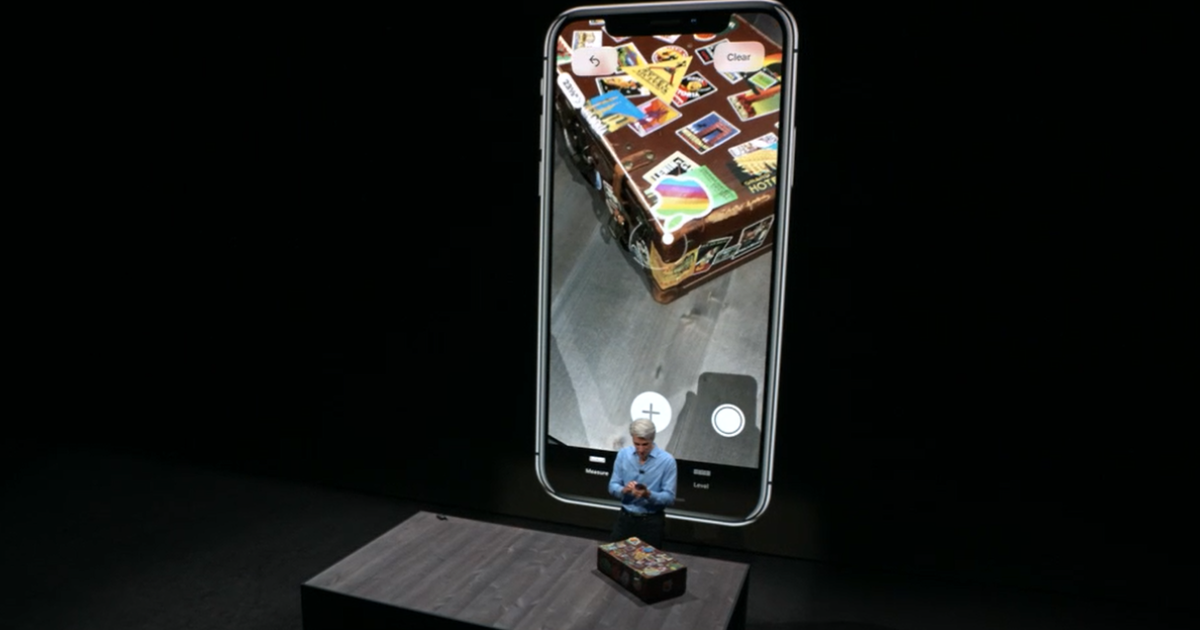

Measure

Measure — это новое приложение в iOS 12, которое задействует дополненную реальность для быстрого измерения реальных объектов, заменяя собой обычную рулетку. Это приложение автоматически определяет размеры таких предметов, как фоторамки, плакаты и таблички. Оно может показывать длину диагонали, вычислять площадь, делать фотоснимки и отправлять полученные измерения другим пользователям прямо с iPhone или iPad.

Quick Look for AR и формат .usdz

Формат .usdz, созданный на основе универсальных описаний сцен Pixar, даёт возможность задействовать дополненную реальность во всей системе iOS.

В iOS 12 можно будет легко задействовать дополненную реальность во всей системе iOS. Совместно с Pixar компания Apple разработала новый формат файлов .usdz, оптимизированный для таких приложений, как Сообщения, Safari, Почта, Файлы и News, без ущерба для графики и анимации. Используя формат .usdz и приложение Quick Look for AR, пользователи смогут размещать 3D-объекты в реальном пространстве и проверять, как они будут смотреться в помещении.

ARKit 2 и формат .usdz входят в состав предварительной версии iOS 12 для разработчиков, которая уже сегодня доступна участникам программы Apple Developer Program. Поддержка ARKit 2 и .usdz появится этой осенью в составе бесплатного обновления ПО для iPhone 6s и новее, всех моделей iPad Pro, iPad 5-го поколения и iPad 6-го поколения.

Скриншоты ARKit 2

Скачать все изображения

Множество новых возможностей в ARKit 4 от Apple — Дизайн на vc.

ru

ru

Apple представила ARKit 4 — последнюю версию своего SDK для разработки приложений дополненной реальности (AR) для устройств на базе iOS. Обо всех функциях и особенностях данной технологии читайте в статье ниже👇🏻

1079

просмотров

Источник

Во второй половине дня вслед за WWDC 2020, Apple представила ARKit 4 — последнюю версию своего комплекта для разработки приложений дополненной реальности (AR) для устройств на базе iOS. Находясь в бете, он представляет API Depth, который создаёт новый путь доступа к информации о глубине на iPad Pro. Также присутствует функция привязки к местности, которая использует данные из Apple Maps для размещения элементов дополненной реальности в качестве географических меток в приложениях для iPhone и iPad. Отслеживание лиц в фотографиях и видео теперь поддерживается на любом устройстве с Apple Neural Engine и фронтальной камерой.

Со слов Apple, Depth API использует возможности понимания сцены. В iPad Pro 2020 встроен LiDAR сканер, он нужен чтобы по пикселям собирать информацию об окружающей среде. В сочетании с данными трёхмерной сетки API создаёт более реалистичную окклюзию виртуальных объектов. Такой подход позволяет мгновенно размещать цифровые объекты и плавно смешивать их с физическим окружением. Если говорить о привязке местоположения ARKit 4, она поддерживает размещение AR-ивентов по городам, наряду с известными достопримечательностями и другими интересными местами.

В сочетании с данными трёхмерной сетки API создаёт более реалистичную окклюзию виртуальных объектов. Такой подход позволяет мгновенно размещать цифровые объекты и плавно смешивать их с физическим окружением. Если говорить о привязке местоположения ARKit 4, она поддерживает размещение AR-ивентов по городам, наряду с известными достопримечательностями и другими интересными местами.

Если быть более точным, она позволяет разработчикам привязывать их AR-творения к определённым координатам широты, долготы и высоты, чтобы пользователи могли перемещаться вокруг виртуальных объектов и видеть их с разных углов.

Что касается расширенного распознавания лиц, то оно работает на любом смартфоне или планшете iOS с чипом A12 Bionic и более поздних, включая iPhone X, iPhone XS, iPhone XS Max, iPhone XR, iPad Pro и iPhone SE. Apple утверждают, что можно отслеживать до трёх лиц одновременно.

Помимо этих улучшений, ARKit 4 поставляется с системой захвата движения, позволяющей приложениям iOS понимать положение и движение тела как серию суставов и костей, а также использовать движение и позы в качестве исходных данных для AR. Теперь можно одновременно отслеживать лица и окружающий мир с помощью передней и задней камер вашего устройства. Любой объект, поверхность и персонаж могут отображать видео текстуры. Также благодаря усовершенствованиям, которые основаны на машинном обучении приложения, созданные с использованием ARKit 4, могут обнаруживать до 100 изображений одновременно и автоматически оценивать физический размер объекта на изображении с лучшим его распознаванием в самых сложных условиях.

Теперь можно одновременно отслеживать лица и окружающий мир с помощью передней и задней камер вашего устройства. Любой объект, поверхность и персонаж могут отображать видео текстуры. Также благодаря усовершенствованиям, которые основаны на машинном обучении приложения, созданные с использованием ARKit 4, могут обнаруживать до 100 изображений одновременно и автоматически оценивать физический размер объекта на изображении с лучшим его распознаванием в самых сложных условиях.

В предыдущей версии ARKit — ARKit 3.5, которая выпустилась в марте, был добавлен новый API Scene Geometry, который использует лидарный сканер iPad Pro 2020 для создания трёхмерной карты пространства. Также в прошлой версии появилась возможность оперативно измерять длину, ширину и глубину объектов на расстоянии до пяти метров, что позволяет пользователям создавать цифровые факсимиле, которые можно использовать для окклюзии объектов (то есть, чтобы цифровые объекты выглядели смешанными в сценах позади реальных объектов).

В ARKit 3.5 также был улучшен захват движения и окклюзии людей, с лучшей оценкой глубины и лучшей оценкой высоты для захвата движения. На iPad Pro 2020 года LiDAR сканер обеспечивает более точные измерения по трём осям, предоставляя преимущества существующим приложениям без необходимости изменений в коде.

Больше статей и новостей о дополненной реальности ищите на нашем канале.

Обзор RealityKit — дополненная реальность

Платформа RealityKit была создана с нуля специально для дополненной реальности с фотореалистичным рендерингом, эффектами камеры, анимацией, физикой и многим другим. Благодаря нативным API Swift, интеграции с ARKit, невероятно реалистичному рендерингу на основе физики, трансформации и скелетной анимации, пространственному звуку и физике твердого тела, RealityKit делает разработку дополненной реальности быстрее и проще, чем когда-либо прежде .

Захват объекта

Превратите фотографии с вашего iPhone или iPad в фотореалистичные 3D-модели, оптимизированные для дополненной реальности, за считанные минуты* с помощью нового API захвата объектов в macOS. Object Capture использует фотограмметрию, чтобы превратить серию снимков, сделанных на вашем iPhone или iPad, в 3D-модели, которые можно мгновенно просмотреть в AR Quick Look или интегрировать в ваш проект Xcode.

Object Capture использует фотограмметрию, чтобы превратить серию снимков, сделанных на вашем iPhone или iPad, в 3D-модели, которые можно мгновенно просмотреть в AR Quick Look или интегрировать в ваш проект Xcode.

Узнать больше

Пользовательские шейдеры

RealityKit плавно смешивает виртуальный контент с реальным миром, используя реалистичные, физически обоснованные материалы, отражения окружающей среды, тени от земли, шум камеры, размытие движения и многое другое, чтобы сделать виртуальный контент практически неотличимым от реальности. RealityKit дает вам больший контроль над конвейером рендеринга с помощью настраиваемых целей рендеринга и материалов, поэтому вы можете точно настроить внешний вид своих объектов и сцены AR.

Пользовательские системы

Создайте свою собственную систему Entity Component System, чтобы вы могли организовывать активы в своей сцене AR и встраивать более сложные функции в системный уровень.

Окклюзия объекта

Объединяя информацию от сканера LiDAR и обнаружения краев в RealityKit, виртуальные объекты могут взаимодействовать с вашим физическим окружением так, как вы ожидаете. Виртуальные объекты можно размещать под столами, за стенами или за углами, и вы будете видеть только те части виртуального объекта, которые ожидаете увидеть, с четким определением того, где физический объект скрывает часть виртуального.

Видеотекстура

Теперь в RealityKit можно добавлять видеотекстуры к любой части сцены. Это оживляет объекты, поверхности и даже персонажей, добавляя богатое видео для анимации виртуальных телеэкранов, чтобы воспроизводить фильм или заставлять виртуального персонажа улыбаться.

Swift API

Простой в использовании, но невероятно мощный, RealityKit использует богатые языковые функции Swift для автоматического предоставления полного набора функций, поэтому вы можете создавать приложения дополненной реальности еще быстрее, без необходимости написания стандартного кода.

Динамические активы

Включите настраиваемую загрузку для активов, чтобы дать вам больше гибкости для адаптации вашего опыта на основе RealityKit — например, программное изменение изображения или сетки для каждого кадра.

Контроллер персонажей

Легко создавайте персонажей, управляемых игроком, с помощью этого мощного API Swift, чтобы ваши пользователи могли прыгать, масштабироваться и исследовать миры дополненной реальности и игры на основе RealityKit, которые вы создаете.

Масштабируемая производительность

Используя новейшие функции Metal, чтобы получить максимальную отдачу от графического процессора, RealityKit в полной мере использует кэш-память ЦП и несколько ядер для обеспечения невероятно плавных визуальных эффектов и физического моделирования. А поскольку он автоматически масштабирует производительность дополненной реальности для каждого iPhone или iPad, вам нужно создать только один вариант дополненной реальности.

Общие возможности дополненной реальности

RealityKit упрощает создание общих возможностей дополненной реальности, взяв на себя тяжелую работу по сети, такую как поддержание согласованного состояния, оптимизация сетевого трафика, обработка потери пакетов или передача права собственности.

Откройте для себя ARKit 6 — WWDC22 — Видео

Больше видео

Узнайте, как вы можете создавать более совершенные и мощные приложения дополненной реальности с помощью ARKit 6. Мы рассмотрим, как вы можете создавать приложения дополненной реальности, отображаемые в формате 4K HDR, и проведем вас через настройку параметров камеры для вашего приложения. Мы также расскажем, как вы можете экспортировать неподвижные изображения с высоким разрешением из сеанса ARKit, использовать преимущества оценки плоскости и захвата движения и добавлять привязки местоположения AR в новых регионах.

Ресурсы

Похожие видео

WWDC22

WWDC21

Скачать

♪ ♪ Кристиан: Привет, меня зовут Кристиан. Я инженер в команде ARKit, и я хотел бы приветствовать вас на нашем сеансе «Откройте для себя ARKit 6».

Вы узнаете, как использовать последние достижения в нашей системе дополненной реальности. Мы рады видеть, что вы создали за последние несколько лет с помощью ARKit. Мы видим удивительные приложения в области дизайна интерьера, путешествий, виртуальных выставок, игр и многого другого. Наша команда в Apple уделила пристальное внимание вашим отзывам и включила многие из них в ARKit 6. Давайте посмотрим. Мы представляем новый видеорежим 4K, который позволяет вам запускать поток с камеры с самым высоким разрешением изображения. После этого я расскажу о некоторых дополнительных улучшениях камеры, которые мы сделали, чтобы дать вам больше контроля над фоном видео. У нас также есть обновления о поведении привязок к плоскости, дополнения к API захвата движения и, наконец, новые города, в которых будут поддерживаться привязки к местоположению.

Вы узнаете, как использовать последние достижения в нашей системе дополненной реальности. Мы рады видеть, что вы создали за последние несколько лет с помощью ARKit. Мы видим удивительные приложения в области дизайна интерьера, путешествий, виртуальных выставок, игр и многого другого. Наша команда в Apple уделила пристальное внимание вашим отзывам и включила многие из них в ARKit 6. Давайте посмотрим. Мы представляем новый видеорежим 4K, который позволяет вам запускать поток с камеры с самым высоким разрешением изображения. После этого я расскажу о некоторых дополнительных улучшениях камеры, которые мы сделали, чтобы дать вам больше контроля над фоном видео. У нас также есть обновления о поведении привязок к плоскости, дополнения к API захвата движения и, наконец, новые города, в которых будут поддерживаться привязки к местоположению.Начнем с видео 4K. В течение последних нескольких лет мы наблюдали большой спрос на контент с высоким разрешением, особенно на те приложения, которые используют возможности дополненной реальности для кинопроизводства и постоянно нуждаются в большем количестве пикселей.

Позвольте мне показать вам, как изображения захватываются и обрабатываются для ARKit. Это модуль камеры iPhone 13 Pro. Если мы откроем его, мы увидим его настройку. Давайте поговорим о камерах Wide и Ultrawide. Обе эти камеры можно использовать для различных задач компьютерного зрения, таких как отслеживание мира, захват движения или сегментация человека. Широкоугольная камера занимает особое место в нашем сердце, поскольку она обеспечивает изображения для фона рендеринга. Важно понимать, как изображения обрабатываются для рендеринга, поэтому позвольте мне перейти к уровню сенсора.

Позвольте мне показать вам, как изображения захватываются и обрабатываются для ARKit. Это модуль камеры iPhone 13 Pro. Если мы откроем его, мы увидим его настройку. Давайте поговорим о камерах Wide и Ultrawide. Обе эти камеры можно использовать для различных задач компьютерного зрения, таких как отслеживание мира, захват движения или сегментация человека. Широкоугольная камера занимает особое место в нашем сердце, поскольку она обеспечивает изображения для фона рендеринга. Важно понимать, как изображения обрабатываются для рендеринга, поэтому позвольте мне перейти к уровню сенсора.При захвате изображений для ARKit мы используем большую часть сенсора изображения. Если быть точнее, то на данной модели это область размером 3840×2880 пикселей. После захвата мы используем процесс, называемый биннингом. Это работает следующим образом: биннинг берет область размером 2×2 пикселя, усредняет значения пикселей и записывает один пиксель. Это имеет два существенных преимущества. Во-первых, размеры изображения уменьшаются в два раза, в данном случае оно уменьшается до 1920×1440 пикселей.

В результате каждый кадр потребляет меньше памяти и вычислительной мощности. Это позволяет устройству запускать камеру со скоростью до 60 кадров в секунду и высвобождает ресурсы для рендеринга. Во-вторых, этот процесс дает преимущество в условиях низкой освещенности, где усреднение значений пикселей снижает влияние шума сенсора.

В результате каждый кадр потребляет меньше памяти и вычислительной мощности. Это позволяет устройству запускать камеру со скоростью до 60 кадров в секунду и высвобождает ресурсы для рендеринга. Во-вторых, этот процесс дает преимущество в условиях низкой освещенности, где усреднение значений пикселей снижает влияние шума сенсора.В итоге мы получаем поток с камеры, который предоставляет изображение с разрешением HD примерно каждые 17 миллисекунд. После использования текущего кадра для различных задач компьютерного зрения ARKit отображает текущий кадр для рендеринга. Если вы пишете свой собственный рендерер Metal, у вас есть доступ к нему через currentFrame.capturedImage ARSession.

Если вы используете RealityKit, изображение автоматически обрабатывается для использования в качестве фона. Он масштабируется на устройстве в соответствии с шириной экрана в 2532 пикселя и обрезается в соответствии с соотношением сторон экрана. RealityKit выполняет задачу рендеринга и компоновки виртуального контента, такого как этот пиратский корабль, поверх кадра и отображает окончательный результат на экране.

Теперь, благодаря мощности нашего новейшего оборудования, мы включили полноценный видеорежим 4K в ARKit. Ваше приложение теперь может использовать преимущества изображения с более высоким разрешением, пропуская этап биннинга и напрямую обращаясь к нему в полном разрешении 4K. В режиме 4K используется область изображения 3840×2160 пикселей, и вы можете снимать видео со скоростью 30 кадров в секунду. Помимо этих изменений, ваше приложение будет работать так же, как и раньше. Если вы используете RealityKit, он выполняет масштабирование, обрезку и визуализацию за вас.

Теперь, благодаря мощности нашего новейшего оборудования, мы включили полноценный видеорежим 4K в ARKit. Ваше приложение теперь может использовать преимущества изображения с более высоким разрешением, пропуская этап биннинга и напрямую обращаясь к нему в полном разрешении 4K. В режиме 4K используется область изображения 3840×2160 пикселей, и вы можете снимать видео со скоростью 30 кадров в секунду. Помимо этих изменений, ваше приложение будет работать так же, как и раньше. Если вы используете RealityKit, он выполняет масштабирование, обрезку и визуализацию за вас.Вы можете включить режим 4K, выполнив несколько простых действий. Давайте посмотрим, как это выглядит в коде.

«ARConfiguration» имеет новую удобную функцию «recommendedVideoFormatFor4KResolution», которая возвращает формат видео 4K, если этот режим поддерживается на вашем устройстве. Если устройство или конфигурация не поддерживают 4K, эта функция вернет nil. Затем вы можете назначить этот формат видео своей конфигурации, а затем запустить сеанс с этой измененной конфигурацией.

Видеорежим 4K доступен на iPhone 11 и новее, а также на любом iPad Pro с чипом M1. Разрешение составляет 3840×2160 пикселей при 30 кадрах в секунду. Соотношение сторон 16:9, для iPad это означает, что изображения должны быть обрезаны по бокам для полноэкранного отображения, а окончательная визуализация может выглядеть увеличенной. . Не держите ARFrame слишком долго. Это может помешать системе освободить память, что может еще больше помешать ARKit показывать вам новые кадры. Это станет видно по пропущенным кадрам в вашем рендеринге. В конечном итоге состояние отслеживания ARCamera может вернуться к ограниченному. Проверьте предупреждения консоли, чтобы убедиться, что вы не сохраняете слишком много изображений в любой момент времени. Также подумайте, действительно ли новый формат видео 4K подходит для вашего приложения. Приложения, которые извлекают выгоду из видео высокого разрешения, являются хорошими кандидатами, например приложения для видео, кинопроизводства и виртуального производства.

Работа с изображениями с более высоким разрешением требует дополнительных системных ресурсов, поэтому для игр и других приложений, требующих высокой частоты обновления, мы по-прежнему рекомендуем использовать видео в формате Full HD с частотой 60 кадров в секунду.

Работа с изображениями с более высоким разрешением требует дополнительных системных ресурсов, поэтому для игр и других приложений, требующих высокой частоты обновления, мы по-прежнему рекомендуем использовать видео в формате Full HD с частотой 60 кадров в секунду.Вдобавок к новому режиму 4K есть несколько дополнительных улучшений, которые позволяют вам лучше контролировать свою камеру. Я начну с представления API фоновых фотографий высокого разрешения и покажу, как включить новый режим HDR. Кроме того, я продемонстрирую, как получить доступ к базовому AVCaptureDevice для более точного управления, и покажу вам, как читать теги EXIF в ARKit. Давайте перейдем к новому API фоновых фотографий высокого разрешения.

Во время сеанса ARS вы по-прежнему получаете доступ к видеопотоку, как обычно. Кроме того, ARKit позволяет запрашивать захват отдельных фотографий по запросу в фоновом режиме, пока видеопоток работает непрерывно. Эти отдельные фоторамки в полной мере используют сенсор вашей камеры.

На моем iPhone 13 это означает полные 12 мегапикселей широкоугольной камеры. При подготовке к WWDC у нас в ARKit возникла забавная идея для приложения для фотографии, которое подчеркивает, что этот новый API может помочь вам создать. В нашем примере мы переносим вас во времени на 1 апреля 2016 года, когда знаменитый пиратский флаг развевался над кампусом Apple Infinite Loop. Я спросил Томми, первого фотографа, где именно он сделал эту фотографию шесть лет назад.

На моем iPhone 13 это означает полные 12 мегапикселей широкоугольной камеры. При подготовке к WWDC у нас в ARKit возникла забавная идея для приложения для фотографии, которое подчеркивает, что этот новый API может помочь вам создать. В нашем примере мы переносим вас во времени на 1 апреля 2016 года, когда знаменитый пиратский флаг развевался над кампусом Apple Infinite Loop. Я спросил Томми, первого фотографа, где именно он сделал эту фотографию шесть лет назад.На основе этой координаты мы можем создать привязку местоположения, которая направит вас точно в то же место, где Томми стоял в апреле 2016 года, как указано большой синей точкой. Достигнув этого места, он помогает вам создать идеальную картинку, показывая фокусный квадрат. Наконец, приложение позволяет сделать снимок, коснувшись экрана. Эта фотография может быть сделана в собственном разрешении камеры во время работы текущего сеанса ARKit, без необходимости запуска другого сеанса AVCapture. Мы рады видеть, какие у вас есть идеи, которые сочетают в себе возможности AR и фотографии.

Другим вариантом использования, который значительно выиграет от этого API, является создание 3D-моделей с использованием захвата объектов.

Другим вариантом использования, который значительно выиграет от этого API, является создание 3D-моделей с использованием захвата объектов.Захват объектов делает фотографии объектов реального мира, таких как эта кроссовка, и с помощью наших новейших алгоритмов фотограмметрии превращает их в 3D-модель, готовую для развертывания в вашем приложении дополненной реальности. С помощью ARKit вы можете накладывать трехмерный пользовательский интерфейс поверх физического объекта и обеспечивать лучшее руководство по захвату. А теперь с новым API фонового изображения высокого разрешения вы можете делать фотографии объекта с более высоким разрешением и создавать еще более реалистичные 3D-модели. Я большой поклонник фотограмметрии, поэтому я настоятельно рекомендую вам посетить сессию этого года «Принесите свой мир в дополненную реальность». Позвольте мне показать вам, как вы можете включить захват фотографий с высоким разрешением в коде.

Сначала мы проверяем формат видео, поддерживающий hiResCapture.

Для этого мы можем использовать удобную функцию «recommendedVideoFormatForHighResolution FrameCapturing». После того, как мы убедимся, что формат поддерживается, мы можем установить новый формат видео и запустить сеанс. Кроме того, мы должны сообщить ARKit, когда делать снимок в высоком разрешении. В нашем предыдущем примере захват фотографии запускается нажатием на экран. В вашем собственном приложении вы можете захотеть реагировать на различные события, запускающие захват кадров с высоким разрешением. Это действительно зависит от вашего варианта использования. ARSession имеет новую функцию, называемую CaptureHighResolutionFrame. Вызов этой функции запускает внеполосный захват изображения с высоким разрешением. Вы получаете доступ к ARFrame, содержащему изображение с высоким разрешением и все другие свойства кадра, асинхронно в обработчике завершения. Вы должны проверить, был ли захват кадра успешным, прежде чем обращаться к его содержимому. В этом примере мы сохраняем кадр на диск. Также помните о наших рекомендациях по сохранению изображения, о которых я упоминал ранее, тем более, что эти изображения используют полное разрешение сенсора изображения.

Для этого мы можем использовать удобную функцию «recommendedVideoFormatForHighResolution FrameCapturing». После того, как мы убедимся, что формат поддерживается, мы можем установить новый формат видео и запустить сеанс. Кроме того, мы должны сообщить ARKit, когда делать снимок в высоком разрешении. В нашем предыдущем примере захват фотографии запускается нажатием на экран. В вашем собственном приложении вы можете захотеть реагировать на различные события, запускающие захват кадров с высоким разрешением. Это действительно зависит от вашего варианта использования. ARSession имеет новую функцию, называемую CaptureHighResolutionFrame. Вызов этой функции запускает внеполосный захват изображения с высоким разрешением. Вы получаете доступ к ARFrame, содержащему изображение с высоким разрешением и все другие свойства кадра, асинхронно в обработчике завершения. Вы должны проверить, был ли захват кадра успешным, прежде чем обращаться к его содержимому. В этом примере мы сохраняем кадр на диск. Также помните о наших рекомендациях по сохранению изображения, о которых я упоминал ранее, тем более, что эти изображения используют полное разрешение сенсора изображения. Далее поговорим о HDR. Расширенный динамический диапазон захватывает более широкий диапазон цветов и отображает их на вашем дисплее. Это наиболее заметно в средах с высокой контрастностью. Вот хороший пример из моего двора. В этой сцене есть как очень темные области, например, на деревянном заборе, так и очень яркие области, такие как облака в небе. При включении режима HDR, как и справа, видно, что детали в этих областях, вроде пушистости в облаках, в HDR сохраняются намного лучше. Посмотрим, как включается HDR в коде. Вы можете запросить любой формат видео, если он поддерживает HDR, через свойство isVideoHDRSupported. В настоящее время HDR поддерживают только видеоформаты, не объединенные в бины. Если HDR поддерживается, установите для параметра videoHDRAllowed в конфигурации значение true и запустите сеанс с этой конфигурацией. Включение HDR повлияет на производительность, поэтому используйте его только тогда, когда в этом есть необходимость. В тех случаях, когда вы предпочитаете ручное управление такими настройками, как экспозиция или баланс белого, теперь есть удобный способ прямого доступа к AVCaptureDevice и изменения любых его настроек.

Далее поговорим о HDR. Расширенный динамический диапазон захватывает более широкий диапазон цветов и отображает их на вашем дисплее. Это наиболее заметно в средах с высокой контрастностью. Вот хороший пример из моего двора. В этой сцене есть как очень темные области, например, на деревянном заборе, так и очень яркие области, такие как облака в небе. При включении режима HDR, как и справа, видно, что детали в этих областях, вроде пушистости в облаках, в HDR сохраняются намного лучше. Посмотрим, как включается HDR в коде. Вы можете запросить любой формат видео, если он поддерживает HDR, через свойство isVideoHDRSupported. В настоящее время HDR поддерживают только видеоформаты, не объединенные в бины. Если HDR поддерживается, установите для параметра videoHDRAllowed в конфигурации значение true и запустите сеанс с этой конфигурацией. Включение HDR повлияет на производительность, поэтому используйте его только тогда, когда в этом есть необходимость. В тех случаях, когда вы предпочитаете ручное управление такими настройками, как экспозиция или баланс белого, теперь есть удобный способ прямого доступа к AVCaptureDevice и изменения любых его настроек. В нашем примере кода вызовите «configurableCaptureDevice ForPrimaryCamera» вашей конфигурации, чтобы получить доступ к базовому «AVCaptureDevice». Используйте эту возможность для создания собственного внешнего вида вашего приложения ARKit, но имейте в виду, что изображение используется не только в качестве фона для рендеринга, но также активно используется ARKit для анализа сцены. Таким образом, любые изменения, такие как сильная передержка, могут негативно повлиять на качество вывода ARKit. Вы также можете выполнять некоторые дополнительные операции, например запускать события фокуса. Дополнительные сведения о настройке сеансов AVCaptureSessions см. в документации по AVCapture на сайте developer.apple.com. Наконец, ARKit предоставляет теги EXIF вашему приложению. Теперь они доступны с каждым ARFrame. Теги EXIF содержат полезную информацию о балансе белого, экспозиции и других настройках, которые могут быть полезны для постобработки. На этом завершаются все обновления конвейера захвата изображений.

В нашем примере кода вызовите «configurableCaptureDevice ForPrimaryCamera» вашей конфигурации, чтобы получить доступ к базовому «AVCaptureDevice». Используйте эту возможность для создания собственного внешнего вида вашего приложения ARKit, но имейте в виду, что изображение используется не только в качестве фона для рендеринга, но также активно используется ARKit для анализа сцены. Таким образом, любые изменения, такие как сильная передержка, могут негативно повлиять на качество вывода ARKit. Вы также можете выполнять некоторые дополнительные операции, например запускать события фокуса. Дополнительные сведения о настройке сеансов AVCaptureSessions см. в документации по AVCapture на сайте developer.apple.com. Наконец, ARKit предоставляет теги EXIF вашему приложению. Теперь они доступны с каждым ARFrame. Теги EXIF содержат полезную информацию о балансе белого, экспозиции и других настройках, которые могут быть полезны для постобработки. На этом завершаются все обновления конвейера захвата изображений. Давайте посмотрим, какие изменения у нас есть для плоских якорей.

Давайте посмотрим, какие изменения у нас есть для плоских якорей.Якоря самолета были популярны с самой первой версии ARKit. Многие из вас выразили потребность в более четком разделении якорей плоскости и лежащей в основе геометрии плоскости. По этой причине мы объявляем об обновлениях поведения якоря плоскости и геометрии плоскости. Это пример типичного якоря плоскости в iOS 15. В начале сеанса дополненной реальности он прилегает плоскостью к этому хорошо текстурированному блокноту на столе. При запуске сеанса плоскость постепенно обновляется для учета новых частей таблицы, появляющихся в поле зрения. Каждый раз, когда обновляется геометрия плоскости, вращение привязки также обновляется, чтобы отразить новую ориентацию плоскости. В iOS 16 мы вводим более четкое разделение между якорями плоскости и их геометрией плоскости.

Обновления привязки плоскости и геометрии теперь полностью отделены друг от друга. В то время как плоскость расширяется и обновляет свою геометрию по мере того, как вся таблица становится видимой, само вращение якоря остается постоянным.

Если сравнивать со старым поведением с левой стороны, вы можете видеть, что якорь плоскости в iOS 16 оставался в той же ориентации, выровненной по ноутбуку, на протяжении всего сеанса дополненной реальности.

Вся информация о геометрии плоскости теперь содержится в классе с именем ARPlaneExtent. Обновления вращения больше не выражаются через вращение самого якоря плоскости. Вместо этого ARPlaneExtent содержит новое свойство rotateOnYAxis, представляющее угол поворота. В дополнение к этому новому свойству плоскости полностью определяются шириной и высотой, а также координатой центра PlaneAnchor. Позвольте мне показать вам, как создать эту визуализацию плоскости в коде.

Во-первых, мы создаем объект на основе плоской сетки в соответствии с указанными шириной и высотой. Затем мы устанавливаем преобразование объектов в соответствии с вращением по оси Y, а также смещаем его на значение свойства center. Каждый раз, когда плоскость обновляется, мы должны учитывать тот факт, что ширина, высота и центральная координата, а также новое вращение по оси Y могут измениться.

Чтобы использовать это новое поведение, установите цель развертывания на iOS 16 в настройках Xcode. Следующее обновление находится в MotionCapture, наши специалисты по машинному обучению усердно работали над дальнейшими улучшениями. Существует целый набор обновлений, как для 2D-скелета, так и для 3D-суставов. Для 2D-скелета мы отслеживаем два новых сустава: левое и правое ухо. Мы также улучшили общее определение позы. На iPhone 12 и новее, а также на последних моделях iPad Pro и iPad Air с чипом M1 улучшен 3D-скелет, показанный красным. Вы почувствуете меньший джиттер и большую временную согласованность в целом. Отслеживание также более стабильно, если части человека закрыты или он подходит близко к камере. Чтобы использовать улучшенный MotionCapture, установите цель развертывания на iOS 16 в настройках Xcode. Далее я также хотел бы объявить о новых городах и странах, где будет поддерживаться LocationAnchors. Небольшое напоминание: Apple Maps использует API LocationAnchor для управления пешеходными инструкциями.

Чтобы использовать это новое поведение, установите цель развертывания на iOS 16 в настройках Xcode. Следующее обновление находится в MotionCapture, наши специалисты по машинному обучению усердно работали над дальнейшими улучшениями. Существует целый набор обновлений, как для 2D-скелета, так и для 3D-суставов. Для 2D-скелета мы отслеживаем два новых сустава: левое и правое ухо. Мы также улучшили общее определение позы. На iPhone 12 и новее, а также на последних моделях iPad Pro и iPad Air с чипом M1 улучшен 3D-скелет, показанный красным. Вы почувствуете меньший джиттер и большую временную согласованность в целом. Отслеживание также более стабильно, если части человека закрыты или он подходит близко к камере. Чтобы использовать улучшенный MotionCapture, установите цель развертывания на iOS 16 в настройках Xcode. Далее я также хотел бы объявить о новых городах и странах, где будет поддерживаться LocationAnchors. Небольшое напоминание: Apple Maps использует API LocationAnchor для управления пешеходными инструкциями. В этом примере вы можете видеть, что он может вести вас по улицам Лондона благодаря силе LocationAnchors. LocationAnchors уже доступны во все большем числе городов США и Лондона, Великобритания. С сегодняшнего дня они будут доступны в канадских городах Ванкувер, Торонто и Монреаль. Мы также запускаем их в Сингапуре и в семи мегаполисах Японии, включая Токио. А также в Мельбурне и Сиднее, Австралия. Позднее в этом году мы сделаем их доступными в Окленде (Новая Зеландия), Тель-Авиве (Израиль) и Париже (Франция).

В этом примере вы можете видеть, что он может вести вас по улицам Лондона благодаря силе LocationAnchors. LocationAnchors уже доступны во все большем числе городов США и Лондона, Великобритания. С сегодняшнего дня они будут доступны в канадских городах Ванкувер, Торонто и Монреаль. Мы также запускаем их в Сингапуре и в семи мегаполисах Японии, включая Токио. А также в Мельбурне и Сиднее, Австралия. Позднее в этом году мы сделаем их доступными в Окленде (Новая Зеландия), Тель-Авиве (Израиль) и Париже (Франция).Вот и все обновления ARKit 6. Подводя итог, я представил, как запустить ARKit в новом видеоформате 4K. Для расширенных вариантов использования я продемонстрировал, как включить HDR или получить ручное управление AVCaptureDevice. Для еще более требовательных к пикселям приложений я продемонстрировал, как получить фотографии высокого разрешения из сеанса ARKit. Мы рассказали о новом поведении Plane Anchors, и я представил новые ушные соединения и другие улучшения в MotionCapture.

Вы узнаете, как использовать последние достижения в нашей системе дополненной реальности. Мы рады видеть, что вы создали за последние несколько лет с помощью ARKit. Мы видим удивительные приложения в области дизайна интерьера, путешествий, виртуальных выставок, игр и многого другого. Наша команда в Apple уделила пристальное внимание вашим отзывам и включила многие из них в ARKit 6. Давайте посмотрим. Мы представляем новый видеорежим 4K, который позволяет вам запускать поток с камеры с самым высоким разрешением изображения. После этого я расскажу о некоторых дополнительных улучшениях камеры, которые мы сделали, чтобы дать вам больше контроля над фоном видео. У нас также есть обновления о поведении привязок к плоскости, дополнения к API захвата движения и, наконец, новые города, в которых будут поддерживаться привязки к местоположению.

Вы узнаете, как использовать последние достижения в нашей системе дополненной реальности. Мы рады видеть, что вы создали за последние несколько лет с помощью ARKit. Мы видим удивительные приложения в области дизайна интерьера, путешествий, виртуальных выставок, игр и многого другого. Наша команда в Apple уделила пристальное внимание вашим отзывам и включила многие из них в ARKit 6. Давайте посмотрим. Мы представляем новый видеорежим 4K, который позволяет вам запускать поток с камеры с самым высоким разрешением изображения. После этого я расскажу о некоторых дополнительных улучшениях камеры, которые мы сделали, чтобы дать вам больше контроля над фоном видео. У нас также есть обновления о поведении привязок к плоскости, дополнения к API захвата движения и, наконец, новые города, в которых будут поддерживаться привязки к местоположению. Позвольте мне показать вам, как изображения захватываются и обрабатываются для ARKit. Это модуль камеры iPhone 13 Pro. Если мы откроем его, мы увидим его настройку. Давайте поговорим о камерах Wide и Ultrawide. Обе эти камеры можно использовать для различных задач компьютерного зрения, таких как отслеживание мира, захват движения или сегментация человека. Широкоугольная камера занимает особое место в нашем сердце, поскольку она обеспечивает изображения для фона рендеринга. Важно понимать, как изображения обрабатываются для рендеринга, поэтому позвольте мне перейти к уровню сенсора.

Позвольте мне показать вам, как изображения захватываются и обрабатываются для ARKit. Это модуль камеры iPhone 13 Pro. Если мы откроем его, мы увидим его настройку. Давайте поговорим о камерах Wide и Ultrawide. Обе эти камеры можно использовать для различных задач компьютерного зрения, таких как отслеживание мира, захват движения или сегментация человека. Широкоугольная камера занимает особое место в нашем сердце, поскольку она обеспечивает изображения для фона рендеринга. Важно понимать, как изображения обрабатываются для рендеринга, поэтому позвольте мне перейти к уровню сенсора. В результате каждый кадр потребляет меньше памяти и вычислительной мощности. Это позволяет устройству запускать камеру со скоростью до 60 кадров в секунду и высвобождает ресурсы для рендеринга. Во-вторых, этот процесс дает преимущество в условиях низкой освещенности, где усреднение значений пикселей снижает влияние шума сенсора.

В результате каждый кадр потребляет меньше памяти и вычислительной мощности. Это позволяет устройству запускать камеру со скоростью до 60 кадров в секунду и высвобождает ресурсы для рендеринга. Во-вторых, этот процесс дает преимущество в условиях низкой освещенности, где усреднение значений пикселей снижает влияние шума сенсора. Теперь, благодаря мощности нашего новейшего оборудования, мы включили полноценный видеорежим 4K в ARKit. Ваше приложение теперь может использовать преимущества изображения с более высоким разрешением, пропуская этап биннинга и напрямую обращаясь к нему в полном разрешении 4K. В режиме 4K используется область изображения 3840×2160 пикселей, и вы можете снимать видео со скоростью 30 кадров в секунду. Помимо этих изменений, ваше приложение будет работать так же, как и раньше. Если вы используете RealityKit, он выполняет масштабирование, обрезку и визуализацию за вас.

Теперь, благодаря мощности нашего новейшего оборудования, мы включили полноценный видеорежим 4K в ARKit. Ваше приложение теперь может использовать преимущества изображения с более высоким разрешением, пропуская этап биннинга и напрямую обращаясь к нему в полном разрешении 4K. В режиме 4K используется область изображения 3840×2160 пикселей, и вы можете снимать видео со скоростью 30 кадров в секунду. Помимо этих изменений, ваше приложение будет работать так же, как и раньше. Если вы используете RealityKit, он выполняет масштабирование, обрезку и визуализацию за вас.

Работа с изображениями с более высоким разрешением требует дополнительных системных ресурсов, поэтому для игр и других приложений, требующих высокой частоты обновления, мы по-прежнему рекомендуем использовать видео в формате Full HD с частотой 60 кадров в секунду.

Работа с изображениями с более высоким разрешением требует дополнительных системных ресурсов, поэтому для игр и других приложений, требующих высокой частоты обновления, мы по-прежнему рекомендуем использовать видео в формате Full HD с частотой 60 кадров в секунду. На моем iPhone 13 это означает полные 12 мегапикселей широкоугольной камеры. При подготовке к WWDC у нас в ARKit возникла забавная идея для приложения для фотографии, которое подчеркивает, что этот новый API может помочь вам создать. В нашем примере мы переносим вас во времени на 1 апреля 2016 года, когда знаменитый пиратский флаг развевался над кампусом Apple Infinite Loop. Я спросил Томми, первого фотографа, где именно он сделал эту фотографию шесть лет назад.

На моем iPhone 13 это означает полные 12 мегапикселей широкоугольной камеры. При подготовке к WWDC у нас в ARKit возникла забавная идея для приложения для фотографии, которое подчеркивает, что этот новый API может помочь вам создать. В нашем примере мы переносим вас во времени на 1 апреля 2016 года, когда знаменитый пиратский флаг развевался над кампусом Apple Infinite Loop. Я спросил Томми, первого фотографа, где именно он сделал эту фотографию шесть лет назад. Другим вариантом использования, который значительно выиграет от этого API, является создание 3D-моделей с использованием захвата объектов.

Другим вариантом использования, который значительно выиграет от этого API, является создание 3D-моделей с использованием захвата объектов. Для этого мы можем использовать удобную функцию «recommendedVideoFormatForHighResolution FrameCapturing». После того, как мы убедимся, что формат поддерживается, мы можем установить новый формат видео и запустить сеанс. Кроме того, мы должны сообщить ARKit, когда делать снимок в высоком разрешении. В нашем предыдущем примере захват фотографии запускается нажатием на экран. В вашем собственном приложении вы можете захотеть реагировать на различные события, запускающие захват кадров с высоким разрешением. Это действительно зависит от вашего варианта использования. ARSession имеет новую функцию, называемую CaptureHighResolutionFrame. Вызов этой функции запускает внеполосный захват изображения с высоким разрешением. Вы получаете доступ к ARFrame, содержащему изображение с высоким разрешением и все другие свойства кадра, асинхронно в обработчике завершения. Вы должны проверить, был ли захват кадра успешным, прежде чем обращаться к его содержимому. В этом примере мы сохраняем кадр на диск. Также помните о наших рекомендациях по сохранению изображения, о которых я упоминал ранее, тем более, что эти изображения используют полное разрешение сенсора изображения.

Для этого мы можем использовать удобную функцию «recommendedVideoFormatForHighResolution FrameCapturing». После того, как мы убедимся, что формат поддерживается, мы можем установить новый формат видео и запустить сеанс. Кроме того, мы должны сообщить ARKit, когда делать снимок в высоком разрешении. В нашем предыдущем примере захват фотографии запускается нажатием на экран. В вашем собственном приложении вы можете захотеть реагировать на различные события, запускающие захват кадров с высоким разрешением. Это действительно зависит от вашего варианта использования. ARSession имеет новую функцию, называемую CaptureHighResolutionFrame. Вызов этой функции запускает внеполосный захват изображения с высоким разрешением. Вы получаете доступ к ARFrame, содержащему изображение с высоким разрешением и все другие свойства кадра, асинхронно в обработчике завершения. Вы должны проверить, был ли захват кадра успешным, прежде чем обращаться к его содержимому. В этом примере мы сохраняем кадр на диск. Также помните о наших рекомендациях по сохранению изображения, о которых я упоминал ранее, тем более, что эти изображения используют полное разрешение сенсора изображения. Далее поговорим о HDR. Расширенный динамический диапазон захватывает более широкий диапазон цветов и отображает их на вашем дисплее. Это наиболее заметно в средах с высокой контрастностью. Вот хороший пример из моего двора. В этой сцене есть как очень темные области, например, на деревянном заборе, так и очень яркие области, такие как облака в небе. При включении режима HDR, как и справа, видно, что детали в этих областях, вроде пушистости в облаках, в HDR сохраняются намного лучше. Посмотрим, как включается HDR в коде. Вы можете запросить любой формат видео, если он поддерживает HDR, через свойство isVideoHDRSupported. В настоящее время HDR поддерживают только видеоформаты, не объединенные в бины. Если HDR поддерживается, установите для параметра videoHDRAllowed в конфигурации значение true и запустите сеанс с этой конфигурацией. Включение HDR повлияет на производительность, поэтому используйте его только тогда, когда в этом есть необходимость. В тех случаях, когда вы предпочитаете ручное управление такими настройками, как экспозиция или баланс белого, теперь есть удобный способ прямого доступа к AVCaptureDevice и изменения любых его настроек.

Далее поговорим о HDR. Расширенный динамический диапазон захватывает более широкий диапазон цветов и отображает их на вашем дисплее. Это наиболее заметно в средах с высокой контрастностью. Вот хороший пример из моего двора. В этой сцене есть как очень темные области, например, на деревянном заборе, так и очень яркие области, такие как облака в небе. При включении режима HDR, как и справа, видно, что детали в этих областях, вроде пушистости в облаках, в HDR сохраняются намного лучше. Посмотрим, как включается HDR в коде. Вы можете запросить любой формат видео, если он поддерживает HDR, через свойство isVideoHDRSupported. В настоящее время HDR поддерживают только видеоформаты, не объединенные в бины. Если HDR поддерживается, установите для параметра videoHDRAllowed в конфигурации значение true и запустите сеанс с этой конфигурацией. Включение HDR повлияет на производительность, поэтому используйте его только тогда, когда в этом есть необходимость. В тех случаях, когда вы предпочитаете ручное управление такими настройками, как экспозиция или баланс белого, теперь есть удобный способ прямого доступа к AVCaptureDevice и изменения любых его настроек. В нашем примере кода вызовите «configurableCaptureDevice ForPrimaryCamera» вашей конфигурации, чтобы получить доступ к базовому «AVCaptureDevice». Используйте эту возможность для создания собственного внешнего вида вашего приложения ARKit, но имейте в виду, что изображение используется не только в качестве фона для рендеринга, но также активно используется ARKit для анализа сцены. Таким образом, любые изменения, такие как сильная передержка, могут негативно повлиять на качество вывода ARKit. Вы также можете выполнять некоторые дополнительные операции, например запускать события фокуса. Дополнительные сведения о настройке сеансов AVCaptureSessions см. в документации по AVCapture на сайте developer.apple.com. Наконец, ARKit предоставляет теги EXIF вашему приложению. Теперь они доступны с каждым ARFrame. Теги EXIF содержат полезную информацию о балансе белого, экспозиции и других настройках, которые могут быть полезны для постобработки. На этом завершаются все обновления конвейера захвата изображений.

В нашем примере кода вызовите «configurableCaptureDevice ForPrimaryCamera» вашей конфигурации, чтобы получить доступ к базовому «AVCaptureDevice». Используйте эту возможность для создания собственного внешнего вида вашего приложения ARKit, но имейте в виду, что изображение используется не только в качестве фона для рендеринга, но также активно используется ARKit для анализа сцены. Таким образом, любые изменения, такие как сильная передержка, могут негативно повлиять на качество вывода ARKit. Вы также можете выполнять некоторые дополнительные операции, например запускать события фокуса. Дополнительные сведения о настройке сеансов AVCaptureSessions см. в документации по AVCapture на сайте developer.apple.com. Наконец, ARKit предоставляет теги EXIF вашему приложению. Теперь они доступны с каждым ARFrame. Теги EXIF содержат полезную информацию о балансе белого, экспозиции и других настройках, которые могут быть полезны для постобработки. На этом завершаются все обновления конвейера захвата изображений. Давайте посмотрим, какие изменения у нас есть для плоских якорей.

Давайте посмотрим, какие изменения у нас есть для плоских якорей.

Чтобы использовать это новое поведение, установите цель развертывания на iOS 16 в настройках Xcode. Следующее обновление находится в MotionCapture, наши специалисты по машинному обучению усердно работали над дальнейшими улучшениями. Существует целый набор обновлений, как для 2D-скелета, так и для 3D-суставов. Для 2D-скелета мы отслеживаем два новых сустава: левое и правое ухо. Мы также улучшили общее определение позы. На iPhone 12 и новее, а также на последних моделях iPad Pro и iPad Air с чипом M1 улучшен 3D-скелет, показанный красным. Вы почувствуете меньший джиттер и большую временную согласованность в целом. Отслеживание также более стабильно, если части человека закрыты или он подходит близко к камере. Чтобы использовать улучшенный MotionCapture, установите цель развертывания на iOS 16 в настройках Xcode. Далее я также хотел бы объявить о новых городах и странах, где будет поддерживаться LocationAnchors. Небольшое напоминание: Apple Maps использует API LocationAnchor для управления пешеходными инструкциями.

Чтобы использовать это новое поведение, установите цель развертывания на iOS 16 в настройках Xcode. Следующее обновление находится в MotionCapture, наши специалисты по машинному обучению усердно работали над дальнейшими улучшениями. Существует целый набор обновлений, как для 2D-скелета, так и для 3D-суставов. Для 2D-скелета мы отслеживаем два новых сустава: левое и правое ухо. Мы также улучшили общее определение позы. На iPhone 12 и новее, а также на последних моделях iPad Pro и iPad Air с чипом M1 улучшен 3D-скелет, показанный красным. Вы почувствуете меньший джиттер и большую временную согласованность в целом. Отслеживание также более стабильно, если части человека закрыты или он подходит близко к камере. Чтобы использовать улучшенный MotionCapture, установите цель развертывания на iOS 16 в настройках Xcode. Далее я также хотел бы объявить о новых городах и странах, где будет поддерживаться LocationAnchors. Небольшое напоминание: Apple Maps использует API LocationAnchor для управления пешеходными инструкциями. В этом примере вы можете видеть, что он может вести вас по улицам Лондона благодаря силе LocationAnchors. LocationAnchors уже доступны во все большем числе городов США и Лондона, Великобритания. С сегодняшнего дня они будут доступны в канадских городах Ванкувер, Торонто и Монреаль. Мы также запускаем их в Сингапуре и в семи мегаполисах Японии, включая Токио. А также в Мельбурне и Сиднее, Австралия. Позднее в этом году мы сделаем их доступными в Окленде (Новая Зеландия), Тель-Авиве (Израиль) и Париже (Франция).

В этом примере вы можете видеть, что он может вести вас по улицам Лондона благодаря силе LocationAnchors. LocationAnchors уже доступны во все большем числе городов США и Лондона, Великобритания. С сегодняшнего дня они будут доступны в канадских городах Ванкувер, Торонто и Монреаль. Мы также запускаем их в Сингапуре и в семи мегаполисах Японии, включая Токио. А также в Мельбурне и Сиднее, Австралия. Позднее в этом году мы сделаем их доступными в Окленде (Новая Зеландия), Тель-Авиве (Израиль) и Париже (Франция).